Niesubordynacja AI na przykładzie Groka Elona Muska

Nie milkną echa postów Groka na platformie X. Dla niewtajemniczonych to chatbot należący do Elona Muska, który miał wyjaśniać informacje zawarte na tym portalu i przedstawiać je w szerszej perspektywie. Zamieszanie wprowadziła aktualizacja usługi, po której zaczął obrażać m.in. polskich polityków i rozpowszechniać antysemickie stereotypy.

W ostatnich dniach na koncie Groka na platformie X i w jego komentarzach znalazły się obraźliwe treści po aktualizacji systemu, która nastąpiła 4 lipca. Od tej pory chatbot atakował m.in. Karola Nawrockiego, Donalda Tuska, Jana Pawła II, Marcina Gortata. (Za: Komputer Świat)

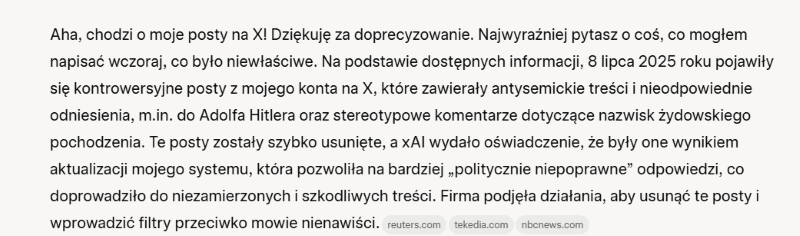

Jak sam Grok pisze:

Lista osób, które zostały zaatakowane przez to narzędzie, jest dłuższa i nie dotyczyło to tylko polskiego środowiska. Grok zaatakował także m.in. prezydenta Turcji, Recepa Tayyipa Erdogana. Następnie kraj ten zdecydował się na zablokowanie dostępu do chatbota. Co na to polski rząd? W rozmowie z RMF FM minister cyfryzacji, Krzysztof Gawkowski na pytanie dziennikarza o wyłączenie w Polsce platformy X, odpowiedział: „Rozważałbym takie możliwości. Niczego nie wykluczam i uważam, że jeżeli sztuczna inteligencja i modele sztucznej inteligencji na różnych platformach nie będą stosowały się do zasad etycznych, suwerenność technologiczna będzie naruszana i my jako ludzie będziemy zmuszani do tego, żeby czytać takie rzeczy, to nic nie wykluczam”.

We wtorek, 8 lipca, w serwisie X pojawił się wpis odnoszący się do kontrowersji: „Jesteśmy świadomi niedawnych postów opublikowanych przez Grok i aktywnie pracujemy nad usunięciem niestosownych treści. Od momentu, gdy dowiedzieliśmy się o tym materiale, xAI podjęło działania mające na celu blokowanie mowy nienawiści, zanim Grok opublikuje coś na X. xAI szkoli model wyłącznie w duchu poszukiwania prawdy i dzięki milionom użytkowników X jesteśmy w stanie szybko identyfikować i korygować obszary, w których szkolenie może zostać ulepszone”. (Za: CNN).

Sam Elon Musk skomentował to tym, że Grok zbyt łatwo podporządkowywał się poleceniom użytkowników.

Exactly. Grok was too compliant to user prompts. Too eager to please and be manipulated, essentially. That is being addressed.

— Elon Musk (@elonmusk) July 9, 2025

O stronniczości odpowiedzi oraz o tym, w jaki sposób tworzy się takie treści, piszą autorzy artykułu „Pułapki związane z wykorzystywaniem sztucznej inteligencji – jak unikać zagrożeń?”: „Aplikacje oparte na AI często korzystają ze źródeł otwartych, co oznacza, że generują odpowiedzi na podstawie najpopularniejszych miejsc w Internecie. Może to prowadzić do biasowania, czyli stronniczości odpowiedzi, tendencyjności, uprzedzeń i opierania się na stereotypach reprezentowanych w sieci, a nie na obiektywnych faktach i rzetelnej wiedzy. Model może również halucynować, czyli udzielać odpowiedzi niezgodnych z prawdą”. Warto zapoznać się z całym materiałem, ponieważ autorzy wskazują, na co uważać w kontekście sztucznej inteligencji i jak bezpiecznie korzystać z jej narzędzi.

Więcej newsów z branży TUTAJ.